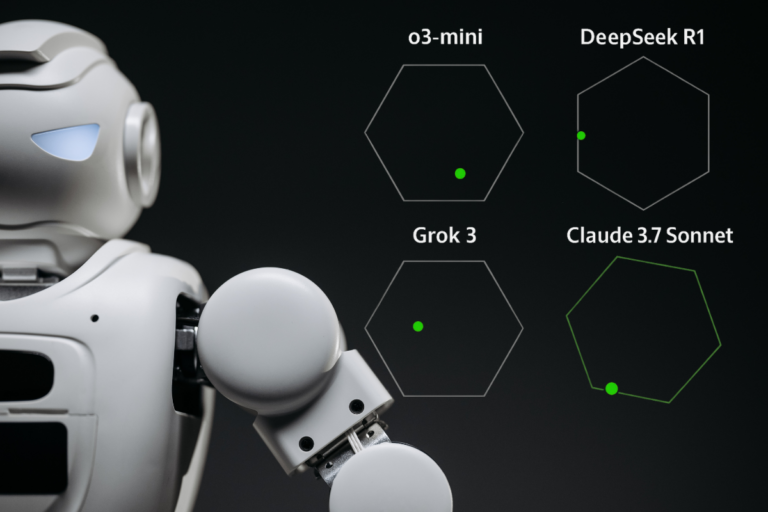

Por que comparar modelos de IA com testes padronizados?

Com o crescimento acelerado da inteligência artificial, tornou-se essencial aplicar testes padronizados para avaliar com precisão o desempenho dos modelos de linguagem. Esses benchmarks funcionam como um “vestibular técnico” das IAs, medindo sua capacidade de raciocinar, escrever, codificar e resolver problemas complexos. Comparações desse tipo ajudam usuários, pesquisadores e empresas a escolherem o modelo mais adequado para cada necessidade — seja desenvolver software, criar conteúdo ou automatizar tarefas. Sem esses testes, seria impossível identificar com clareza quais modelos entregam mais inteligência por dólar investido.

🔍 Benchmarks Avaliados

1. SWE-bench Verified – Engenharia de Software

Avalia a capacidade dos modelos em resolver problemas reais de engenharia de software extraídos do GitHub.

- Claude 3.7 Sonnet: 62,3% (modo padrão), aumentando para 70,3% com scaffolding personalizado.

- DeepSeek R1: 49,2%, subindo para 57,6% na versão R1-0528.

- o3-mini: 49,3%.

- Grok 3: Dados específicos não disponíveis; desempenho anedótico sugere boas capacidades em código.

2. TAU-bench – Uso de Ferramentas (Agentic Tool Use)

Testa a habilidade dos modelos em interagir com ferramentas externas para completar tarefas complexas.

- Claude 3.7 Sonnet: 81,2% em tarefas de varejo e 58,4% em tarefas com companhias aéreas.

- o3-mini: 73,5% (varejo) e 54,2% (companhias aéreas).

- DeepSeek R1: 63,9% (varejo) e 53,5% (companhias aéreas).

- Grok 3: Sem dados oficiais, mas desempenho geral é considerado competitivo.

3. GPQA Diamond – Raciocínio em Nível de Pós-Graduação

Avalia o raciocínio em questões de nível de doutorado em ciências e matemática.

- Claude 3.7 Sonnet: 84,8% com modo de pensamento estendido.

- DeepSeek R1: 81,0% na versão R1-0528.

- o3-mini: 79,7%.

- Grok 3: Dados não divulgados, mas especula-se desempenho alto.

4. AIME 2024/2025 – Matemática Competitiva

Avalia a habilidade dos modelos em resolver problemas matemáticos usados em olimpíadas de matemática.

- Grok 3: 93,3%, o melhor desempenho da lista.

- DeepSeek R1: 91,4% (AIME 2024) e 87,5% (AIME 2025).

- o3-mini: 87,3%.

- Claude 3.7 Sonnet: 80,0% com raciocínio estruturado ativado.

🏆 Conclusão: Qual Modelo Escolher?

- Claude 3.7 Sonnet é o mais completo: destaca-se em engenharia de software, uso de ferramentas e raciocínio avançado. Ideal para tarefas que exigem precisão técnica e lógica refinada.

- Grok 3 é o campeão da matemática: com o melhor desempenho no AIME, é uma ótima escolha para aplicações que envolvem lógica pura e cálculos complexos.

- DeepSeek R1 equilibra desempenho e custo: sua performance sólida e eficiência computacional o tornam uma opção atrativa para ambientes com restrições de recursos.

- o3-mini é o modelo enxuto da OpenAI: combina desempenho razoável com leveza e economia, sendo indicado para tarefas cotidianas de linguagem e automações simples.

📊 Para acompanhar o desempenho atualizado desses e de outros modelos, acesse:

🔗 llm-stats.com/models/compare